🎮 UD3P2 – Entrenar una IA con micro:bit (Piedra, papel y tijera)

🧩 Resumen teórico de apoyo

Con esta práctica aprenderemos cómo una inteligencia artificial percibe, representa, aprende y actúa.

Las máquinas reciben datos mediante sensores, los representan como números, aprenden patrones con algoritmos y responden a través de actuadores.

Para “aprender”, la IA necesita conjuntos de datos suficientes y variados para entrenar un modelo. La calidad de esos datos afecta directamente a la precisión y fiabilidad del sistema. Por eso, además de entrenar, hay que evaluar resultados y reflexionar sobre limitaciones y mejoras.

En esta práctica se integra el ciclo completo:

- Cámara de la tableta como sensor que captura imágenes.

- Teachable Machine para entrenar un modelo de clasificación de gestos.

- micro:bit como actuador que muestra el icono reconocido.

🎯 Propósito de la práctica

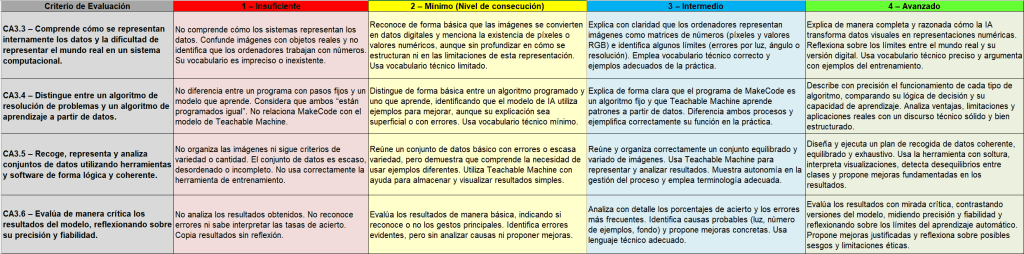

Entrenar una IA que reconozca los gestos de piedra, papel y tijera y conectarla con una micro:bit para visualizar el resultado. Trabajarás la representación de datos (CA3.3), la diferencia algoritmo vs. modelo (CA3.4), la recogida/organización de datos (CA3.5) y el análisis y evaluación crítica del rendimiento (CA3.6).

🧱 Organización del trabajo y entregables

Carpeta compartida del grupo

- Crear una carpeta compartida con este esquema:

/UD3P2_ColorDeGrupo/

/Piedra (imágenes de manos en piedra)

/Papel (imágenes de manos en papel)

/Tijera (imágenes de manos en tijera)

/Nada (imágenes que no son parte del juego)

/Modelo (enlace del modelo)

/Codigo_MakeCode (archivo .hex)

/Evidencias (vídeo corto de la demo)

UD3P2_ColorDeGrupo_HojaDeDatos.docx

- Imágenes y hoja de datos deben guardarse aquí.

- En la hoja de datos, cada integrante escribe en un color distinto: azul, negro y verde.

Entregables obligatorios

- Conjunto de datos organizado en subcarpetas (≥100 imágenes por clase).

- Enlace del modelo exportado (teachable machine).

- Programa de micro:bit (MakeCode): exportado en formato .hex.

- Evidencia de funcionamiento: breve vídeo de la demo.

- Hoja de toma de datos y observaciones (un único archivo del grupo, con colores por persona).

🧠 Enunciado

Entrenamos una Inteligencia Artificial para reconocer los gestos del juego Piedra, Papel y Tijera utilizando Teachable Machine y micro:bit.

CA3.3 – Comprender cómo se representan los datos en los sistemas computacionales

Objetivo 1

Entender cómo un ordenador “ve” una imagen como números (píxeles y valores de color) y qué límites tiene esta representación.

Qué debéis hacer 1

- Revisad qué guarda realmente la cámara: matriz de píxeles con valores RGB.

- Observad una imagen ampliada para identificar píxeles visibles.

- Anotad dos límites de la representación digital (luz, resolución, ruido, ángulo…).

- Relacionadlo con el modelo: las matrices numéricas son la entrada real al aprendizaje.

Materiales 1

Tableta para sacar hacer el BDD (banco de datos) de fotos.

CA3.4 – Diferenciar algoritmo para resolver problemas y algoritmo para aprender un modelo

Objetivo 2

Distinguir entre un algoritmo fijo (programado paso a paso) y un modelo aprendido a partir de datos.

Qué debéis hacer 2

- Identificad en la práctica:

- Algoritmo fijo: programa de MakeCode que, si recibe “piedra”, muestra el icono de piedra, etc.

- Modelo aprendido: Teachable Machine que clasifica imágenes nuevas.

- Explicad ventajas y riesgos del aprendizaje automático (mejora con datos vs. errores por sesgo).

Materiales 2

- Ordenador o tableta

- Micro:bit

- MakeCode

- Teachable Machine.

CA3.5 y CA3.6 – Recoger, analizar y evaluar datos en un modelo de IA

Objetivo 3

Saber recoger y organizar datos, entrenar, analizar resultados y evaluar la precisión, proponiendo mejoras.

Flujo de trabajo por fases 3

Fase 1. Plan de capturas (Datos)

- Clases: Piedra, Papel, Tijera, Nada.

- Mínimo 100 imágenes por clase, variando persona, distancia, ángulo y luz.

- Privacidad: solo manos, fondo neutro; no caras.

Fase 2. Captura y organización

- Guardad las fotos en las subcarpetas correspondientes.

- Comprobad variedad y equilibrio entre clases.

Fase 3. Entrenamiento del modelo

- Teachable Machine → Entrenar.

- Revisad la previsualización de probabilidades por clase.

Fase 4. Integración con micro:bit

- Exportar el modelo a la nube y copiar el enlace.

- MakeCode: configurar Serial USB a 9600, crear variable, leer cadena y comparar texto (“piedra”, “papel”, “tijera”, “nada”) para mostrar iconos.

- Conectar y probar.

Fase 5. Protocolo de pruebas

- Diseñad un test de 20 intentos cruzados (personas y luces distintas).

- Registrad para cada intento: gesto esperado, resultado mostrado y observaciones.

Fase 6. Análisis y evaluación

- Calculad un porcentaje de acierto por gesto y global.

- Detectad errores frecuentes y causas probables.

- Proponed dos mejoras (más ejemplos, fondo, iluminación, distancia, encuadre…).

- Reentrenad, repetid 10 intentos y comparad.

Fase 7. Evidencias y comunicación

- Subid vídeo breve o fotos de la demo funcionando.

- Completad la hoja de datos con conclusiones y mejoras decididas.

Materiales 3

- Tableta con cámara

- Conexión a internet

- Micro:bit

- Soporte para tableta

- MakeCode

- Teachable Machine.

✅ Checklist de calidad antes de entregar

- Carpeta compartida con estructura correcta y todas las subcarpetas.

- BDD imágenes por clase con cantidad y variedad garantizada.

- Enlace del modelo guardado en

/Modelo. - Programa MakeCode funcionando: comparación por cadenas y visualización de iconos.

- Evidencia de demo (vídeo o fotos) en

/Evidencias. - Hoja de datos cumplimentada: tres colores para autorías, respuestas razonadas.

- Conclusiones claras: porcentajes, errores detectados y mejoras propuestas.

🔒 Normas de privacidad y seguridad

- Capturad solo manos. No se permiten rostros ni información personal.

- Fondo preferible uniforme y luz suficiente.

- Paradas técnicas: desconectad la micro:bit antes de manipular cables.

🗂️ Rúbrica

Debe estar conectado para enviar un comentario.